随着科技的飞速发展,计算机在数据存储、处理和通信等方面取得了令人瞩目的成果,其性能已远远超越了人脑。然而,在能效这一关键领域,人脑依然保持着无可比拟的优势。这种差距不仅揭示了计算机技术的局限性,也为科学家们提供了新的研究方向。如今,如何提高计算机的能效已成为全球科研领域的重要课题,这对于应对能源危机、推动可持续发展具有重要意义。

4月17日,英特尔推出了名为Hala Point的全球最大的神经拟态系统,该系统是基于第二代英特尔Loihi 2神经拟态处理器研发,目的在于支持类脑人工智能研究,解决当前AI在效能和可持续性等方面的瓶颈问题。相较于前一代大规模研究系统Pohoiki Springs,Hala Point在架构上进行了升级,其神经元容量提升超过10倍,整体性能增强了12倍。

在人工智能和计算技术领域,追求更高效、节能的计算方法一直是研究的重点。传统的计算方法虽然在处理复杂任务方面取得了显著成就,但其能源消耗始终是一个难以克服的挑战。尤其是在处理大规模数据和复杂机器学习任务时,这些问题更是凸显。因此,科学家们一直在寻找新的方法,以模仿人类大脑的高效能源利用和强大的计算能力。

随着传统的互补金属氧化物半导体集成电路尺寸正在接近物理极限,新型的神经形态计算芯片逐渐发展成为一种潜在的低功耗和高效率的解决方案。具有显示、传感、能量采集和能量存储功能的电子纺织品作为新一代可穿戴电子产品,展现出巨大的应用前景。将神经形态计算忆阻器无缝集成到电子纺织品中,对于有效存储和处理来自功能电子元件的信号至关重要。

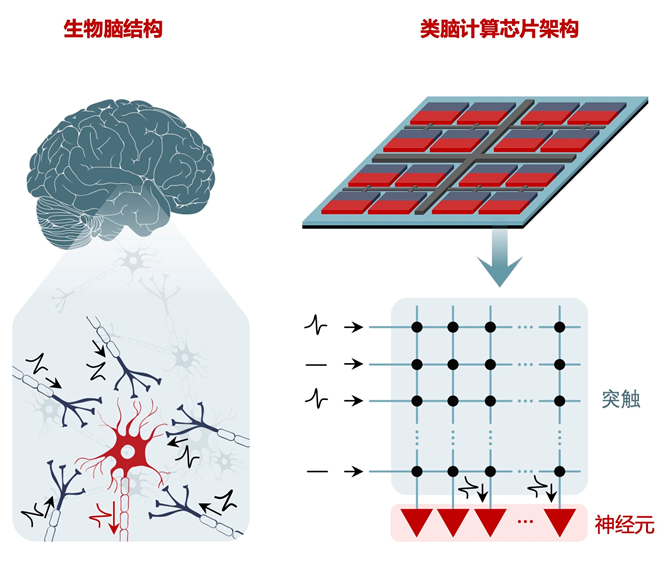

随着人工智能的应用范围越来越广泛,近年来研究人工智能的工作越来越多,其终极目标均是希望利用电子设备构建一个计算系统,能够达到人脑所实现的低功耗、高速度、大容量的并发计算。而人工神经网络就是为了这一仿生过程诞生的。

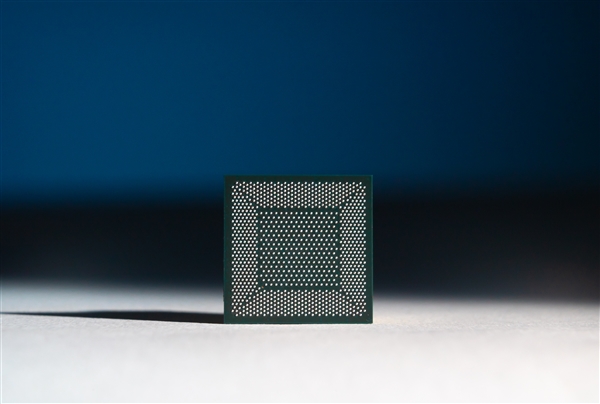

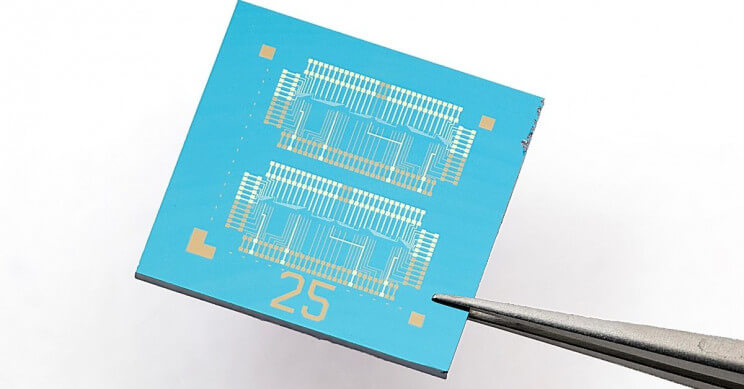

英特尔公司发布其首款7nm神经拟态芯片“Loihi 2”,可模拟100万个神经元。与普通芯片不同的是,神经拟态芯片的计算任务是由许多小单元进行的,单元之间通过类似生物神经的尖峰信号相互通信,并通过尖峰调整其行为。

人脑在20瓦特的能量消耗下即可进行高度智能计算,其主要原因在于单个神经元细胞具备多种线性和非线性运算功能。长期以来,科学家们一直采用传统晶体管电路来模拟人脑中的突触及神经元功能实现神经形态计算。然而,由于布尔逻辑运算需要多个器件组合才能实现,不仅需要大量硬件资源开销,而且在执行信息处理过程中极为耗能,远不及神经元细胞计算的高效性。

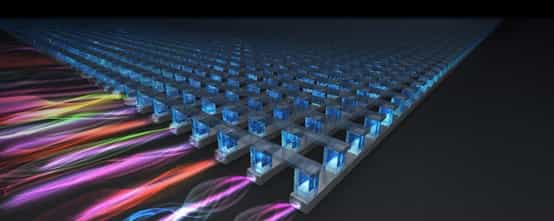

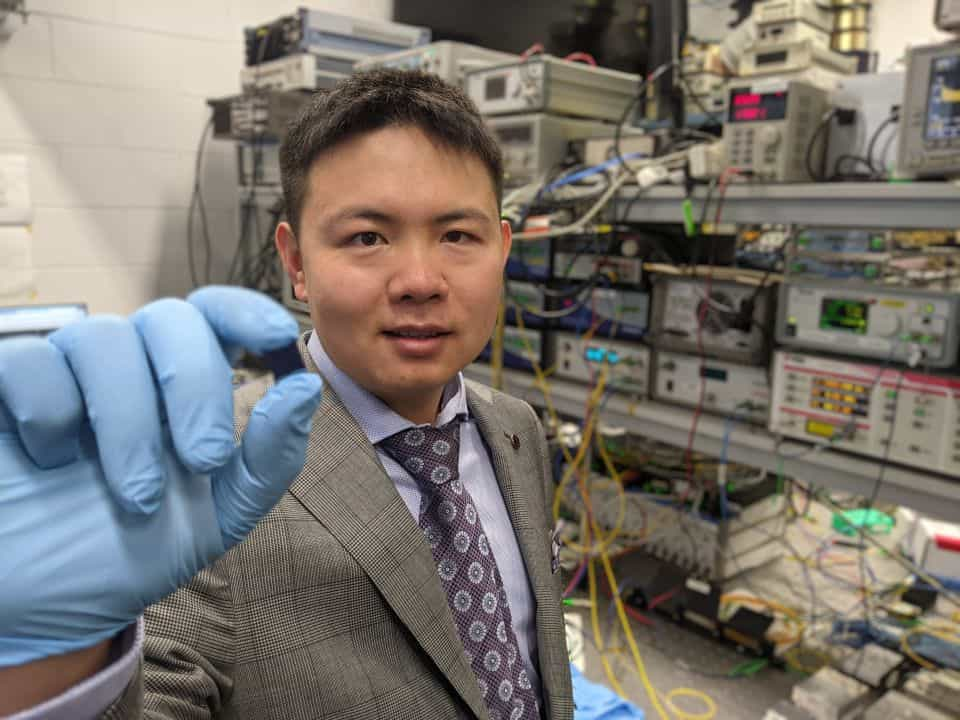

由斯威本科技大学领导的国际研究人员团队展示了世界上最快,最强大的人工智能光学神经形态处理器(AI),其运算速度超过每秒10万亿次运算(TeraOPs / s),并能够处理超大规模数据。

近日,Intel分享了Intel神经拟态研究社区(INRC)的最新进展,联想、罗技、梅赛德斯-奔驰、机器视觉传感器公司Prophesee已经加入,共同探索神经形态计算在商业用例上的价值。

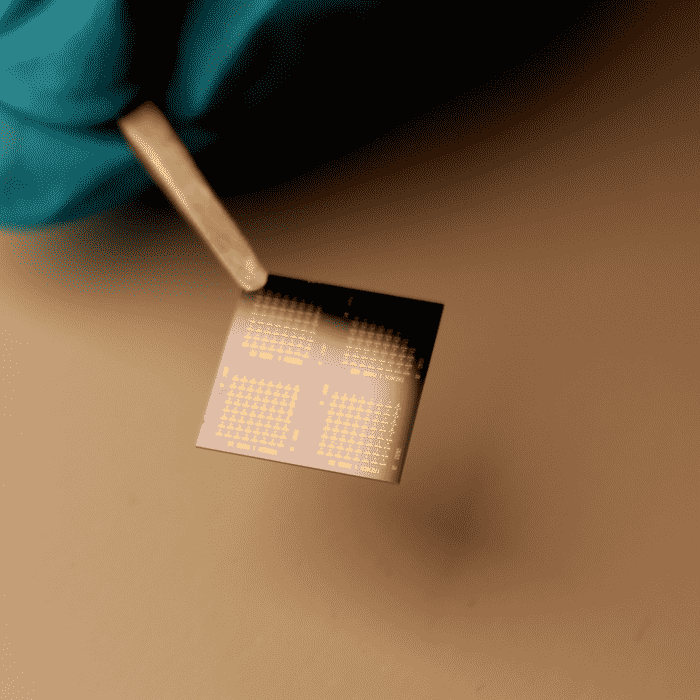

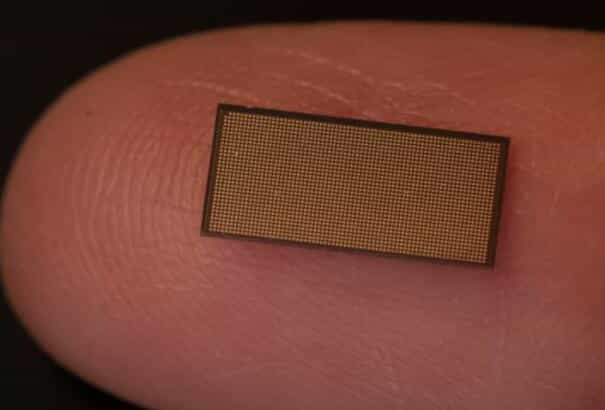

德克萨斯大学的工程师们创造了有史以来最小的存储设备之一,由一种二维材料制成,尺寸为一纳米见方。这种被称为 “原子电阻 “的装置是通过单个原子的运动来工作的,这将为具有难以置信的信息密度的更小的存储系统铺平道路。

一个工程师团队创造了一种能够同时处理和存储数据的2D计算机芯片。根据发表在《自然》杂志上的一项最新研究,EPFL的工程师发明了一种新的计算机芯片,该芯片能够在单个电路中存储和处理数据。下一代计算机芯片由称为二硫化钼(MoS2)的二维材料组成,以前所未有的规模为节能电子产品打开了大门。

我国首篇以“计算机系作为第一完成单位”的论文登上《自然》,论文首次提出“类脑计算完备性”以及软硬件去耦合的类脑计算系统层次结构。“这是一个新颖的观点,并可能被证明是神经形态计算领域以及对人工智能的追求的重大发展。”《自然》的一位审稿人给出评价。

使工程师无法复制大脑的能量效率和脑计算技能的关键是,缺少一种可以独自发挥神经元作用的电子设备。为此,将需要一种特殊的设备,该设备的行为比尚未创建的任何设备都要复杂。现在科学家在忆阻器取得突破,制造出首个像神经元一样起作用的电子器件。

9月1日,亿级神经元类脑计算机重大成果新闻发布会在杭州召开。浙江大学校长吴朝晖院士出席并讲话。他表示,人工智能浪潮正加快智能增强时代的到来,类脑计算机将成为未来计算的主要形态和重要平台,将在模拟脑功能、高效实现AI算法、提升计算能力等方面发挥重要的独特作用。

8月20日消息,近日一项关于在轮椅上安装机器人手臂的研究已有测试版本。该项目主要由埃森哲提供资金和技术支持、英特尔提供神经形态技术以及Applied Brain Research(ABR)公司提供算法,以色列研究团队整合多方技术来进行产品测试。

长期以来,人脑能够以最少的能量处理大量信息的能力使科学家着迷。而在基于硅的计算领域中,从未有过这样的效率。处理大量数据需要大量电能。而且,当人工智能(AI)及其深度学习和机器学习进入现实时,问题就加倍恶化。神经形态芯片发展有助于解决这些问题。

近日,清华大学微纳电子系、北京未来芯片技术高精尖创新中心副教授高滨联合多家合作单位,在《自然·电子》(Nature Electronics)在线发表了题为“类脑计算芯片”(Neuro-inspired computing chips)的综述文章。该文章系统介绍了类脑计算芯片的历史、现状与未来展望,并重点分析了存算一体芯片的设计方法与研究挑战。