近日,清华大学电子系光子计算与集成实验室林星助理教授课题组和上海交通大学电子系熊红凯教授课题组合作,提出了大规模光子神经网络的对偶自适应训练方法,使得网络能够适应大量动态的系统误差累积,实现任务推理性能的巨大提升,在光子神经网络的优化训练领域取得重要进展。

近日,清华大学电子系光子计算与集成实验室林星助理教授课题组和上海交通大学电子系熊红凯教授课题组合作,提出了大规模光子神经网络的对偶自适应训练方法,使得网络能够适应大量动态的系统误差累积,实现任务推理性能的巨大提升,在光子神经网络的优化训练领域取得重要进展。

在《自然·机器智能》杂志上发表的一项新研究中,荷兰国家数学与计算机科学研究所(CWI)科学家展示了类脑神经元如何与新颖的学习方法相结合,能够大规模训练快速节能的尖峰神经网络。潜在的应用包括可穿戴人工智能(AI)、语音识别、增强现实等诸多领域。

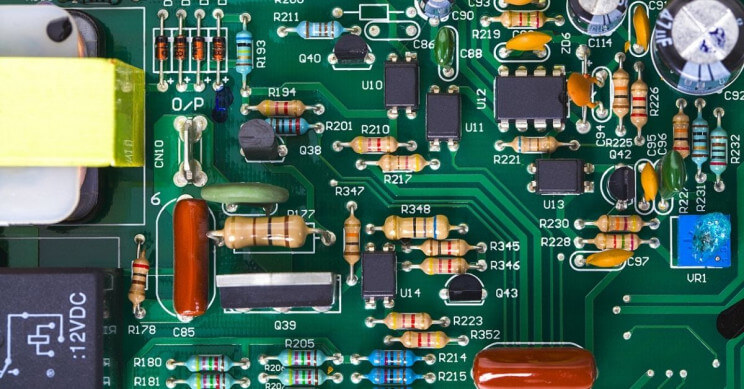

机器学习技术已广泛应用于高性能信息处理领域,与此同时,在解决各类复杂任务时对于计算容量、计算速度以及能耗等的要求也越来越高。然而,现有硬件的计算速度受到传统冯·诺依曼体系结构的严重限制,随着计算过程所需时间的增长,计算效率将变得低下,能耗也会更大。

在深度学习时代,谷歌、Facebook、百度等科技巨头开源了多款框架来帮助开发者更轻松地学习、构建和训练不同类型的神经网络。而这些大公司也花费了很大的精力来维护 TensorFlow、PyTorch 这样庞大的深度学习框架。

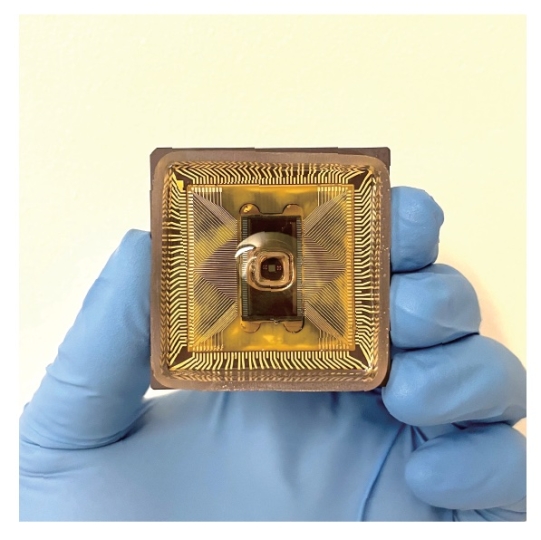

美国哈佛大学工程与应用科学学院 (SEAS)团队与生物技术初创公司DNA Script合作,开发出一种由数百个离子晶体管组成的离子电路,并执行了神经网络计算的核心过程。该研究发表在最近的《先进材料》上。

著名的人工智能企业“深度思维”的新研究表明,神经网络可用于构建比以前更准确的电子密度和相互作用图。该研究有助于科学家更好地理解将分子结合在一起的电子之间的相互作用,还显示了深度学习在量子力学水平上准确模拟物质的前景,使研究人员能够改进计算机设计,在纳米级水平探索有关材料、药物和催化剂的问题。

深度学习是一个能源密集型领域,它的应用受到了限制。但如果这些模型能够以更高的能源效率来运行呢?这是许多研究人员提出的问题,而IBM的一个新团队可能已经找到了答案。

训练大型神经网络并不便宜。以前最大的语言模型使用的硬件成本超过2500万美元。针对GPT-3进行的一次训练至少460万美元的云GPU 收入。结果,研究人员无法为最先进的深度学习模型做出贡献,而从业人员也无法在没有大型公司支持的情况下构建应用程序。hivemind的设计是为了解决这个问题的,这是一个用于在互联网上训练大型神经网络的库。

近日,清华大学微电子所、未来芯片技术高精尖创新中心的钱鹤、吴华强教授团队与合作者在《自然•纳米科技》在线发表研究论文,通过引入具有丰富动态特性的人工树突计算单元,构建了包含突触、树突以及胞体的新型人工神经网络,在提高网络计算准确率的同时显著降低了系统功耗。

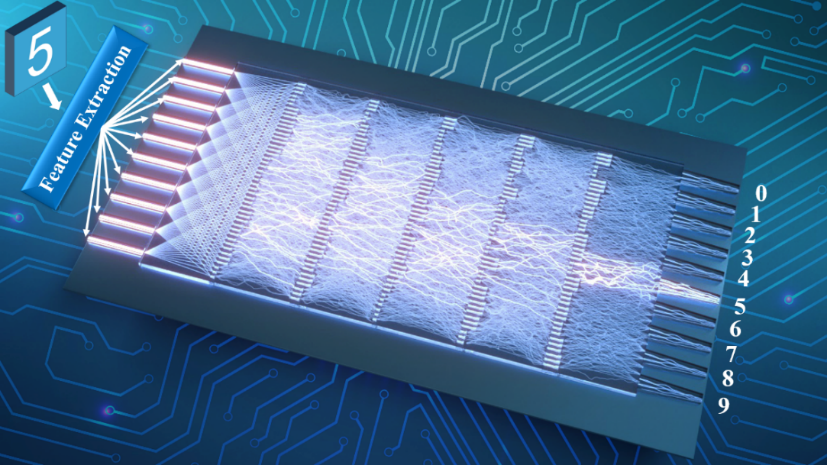

香港科技大学(科大)的科研人员成功研发全球首个可用作深度机器学习(machine learning)的全光学神经网络,不但能让人工智能在处理较复杂的问题上﹕例如辨识事物之间的关系或风险评估等范畴,进一步追近人类,更可在能耗大幅度降低的情况下,以光速进行运算。